原文链接:

http://mp.weixin.qq.com/s/xJhm35IXm_sAPLJ86OwTFA

要点总结:

- Cassandra运行在Mesos容器之中。使用Mesos在读写延迟上面的影响约在5~10%

- 写延迟:在裸服务器上平均是0.43ms,而Mesos上是0.48ms。

- 读延迟:在裸服务器上平均是0.38ms,而在Mesos上是0.44ms。

- 使用Mesos的好处是,可以面向数据中心的资源编程,控制上要灵活很多

- 一共2个数据中心,东西海岸各一个,每个300台机器

- 里面又细分了20个小的集群,这样资源互不干扰

- 每个节点分配:2TB 128G内存,其中Cassandra占用32G (笔者注:默认的25%比例)

- 跟滴滴合并之后,在中国的数据中心就关闭了

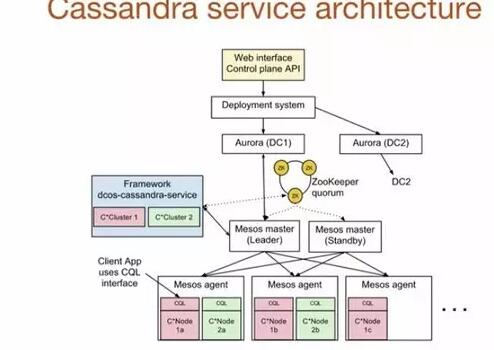

- Mesosphere + Uber + Cassandra = Dcos-Cassandra-Service

- 一个自动化服务,可以很容易在Mesosphere的数据中心及操作系统上自动化部署服务

- https://github.com/mesosphere/dcos-cassandra-service

- 架构如下:

文章评论